Kad sāku strādāt ar mašīnmācīšanās problēmām, tad jūtos panikā, kurš algoritms man jāizmanto? Vai kuru no tām ir viegli pielietot? Ja jūs līdzināties man, tad šis raksts var palīdzēt uzzināt par mākslīgā intelekta un mašīnmācīšanās algoritmiem, metodēm vai paņēmieniem, lai atrisinātu negaidītas vai pat gaidītas problēmas.

Mašīnmācība ir tik spēcīga AI tehnika, kas var efektīvi veikt uzdevumu, neizmantojot skaidras instrukcijas. ML modelis var mācīties no tā datiem un pieredzes. Mašīnmācīšanās lietojumprogrammas ir automātiskas, stabilas un dinamiskas. Lai risinātu šo reālās dzīves problēmu dinamisko raksturu, tiek izstrādāti vairāki algoritmi. Kopumā ir trīs mašīnmācīšanās algoritmu veidi, piemēram, uzraudzīta mācīšanās, bez uzraudzības un mācīšanās pastiprināšana.

Labākie AI un mašīnmācīšanās algoritmi

Piemērotas mašīnmācīšanās tehnikas vai metodes izvēle ir viens no galvenajiem uzdevumiem, lai izstrādātu mākslīgā intelekta vai mašīnmācīšanās projektu. Tā kā ir pieejami vairāki algoritmi, un visiem tiem ir savas priekšrocības un lietderība. Zemāk mēs stāstām par 20 mašīnmācīšanās algoritmiem gan iesācējiem, gan profesionāļiem. Tātad, apskatīsim.

1. Naivie Beiji

Naivu Bayes klasifikators ir varbūtības klasifikators, kas balstīts uz Bayes teorēmu, pieņemot neatkarību starp pazīmēm. Šīs funkcijas dažādās lietojumprogrammās atšķiras. Tā ir viena no ērtajām mašīnmācīšanās metodēm iesācējiem.

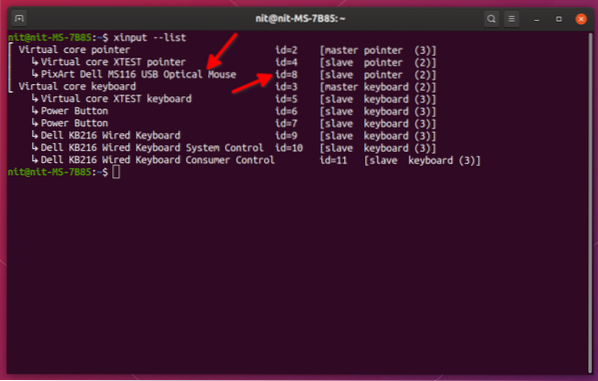

Naivais Bajess ir nosacītas varbūtības modelis. Ņemot vērā klasificējamo problēmu gadījumu, ko attēlo vektors x = (xi … Xn) attēlojot dažas n pazīmes (neatkarīgi mainīgie), tā piešķir pašreizējai instances varbūtībai katram K potenciālajam iznākumam:

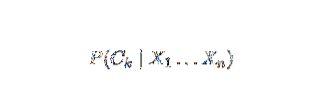

Iepriekš minētā formulējuma problēma ir tāda, ka, ja pazīmju skaits n ir ievērojams vai ja elements var iegūt lielu skaitu vērtību, tad nav iespējams pamatot šādu modeli ar varbūtību tabulām. Tāpēc mēs pārveidojam modeli, lai padarītu to vieglāk vadāmu. Izmantojot Baiesa teorēmu, nosacīto varbūtību var uzrakstīt kā,

Iepriekš minētā formulējuma problēma ir tāda, ka, ja pazīmju skaits n ir ievērojams vai ja elements var iegūt lielu skaitu vērtību, tad nav iespējams pamatot šādu modeli ar varbūtību tabulām. Tāpēc mēs pārveidojam modeli, lai padarītu to vieglāk vadāmu. Izmantojot Baiesa teorēmu, nosacīto varbūtību var uzrakstīt kā,

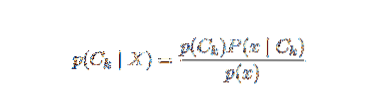

Izmantojot Bajesa varbūtības terminoloģiju, iepriekš minēto vienādojumu var uzrakstīt šādi:

Šis mākslīgā intelekta algoritms tiek izmantots teksta klasifikācijā, t.i.e., noskaņojuma analīze, dokumentu kategorizēšana, surogātpasta filtrēšana un ziņu klasifikācija. Šī mašīnmācīšanās tehnika darbojas labi, ja ievades dati tiek iedalīti iepriekš definētās grupās. Turklāt tas prasa mazāk datu nekā loģistiskā regresija. Tas pārspēj dažādos domēnos.

2. Atbalsta Vector Machine

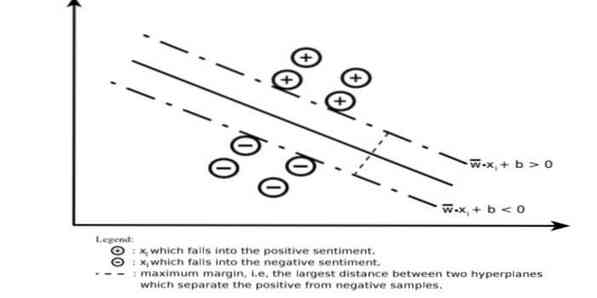

Atbalsta vektora mašīna (SVM) ir viens no visplašāk izmantotajiem uzraudzītajiem mašīnmācīšanās algoritmiem teksta klasifikācijas jomā. Šo metodi izmanto arī regresijai. To var dēvēt arī par Support Vector Networks. Cortes & Vapnik izstrādāja šo metodi binārai klasifikācijai. Uzraudzītais mācību modelis ir mašīnmācīšanās pieeja, kas ļauj secināt marķēto apmācības datu iznākumu.

Atbalsta vektora mašīna konstruē hiperplakni vai hiperplakņu kopu ļoti augstā vai bezgalīgā dimensijā. Tas aprēķina lineārās atdalīšanas virsmu ar maksimālo rezervi konkrētam mācību komplektam.

Tikai ievades vektoru apakškopa ietekmēs piemales izvēli (aplī riņķota attēlā); šādus vektorus sauc par atbalsta vektoriem. Ja lineāra atdalīšanas virsma nepastāv, piemēram, trokšņainu datu klātbūtnē, ir piemēroti SVM algoritmi ar mainīgu mainīgo. Šis klasifikators mēģina sadalīt datu telpu, izmantojot lineāras vai nelineāras robežas starp dažādām klasēm.

SVM ir plaši izmantots modeļu klasifikācijas problēmās un nelineārajā regresijā. Turklāt tas ir viens no labākajiem paņēmieniem automātiskās teksta kategorizēšanas veikšanai. Vislabāk par šo algoritmu ir tas, ka tas neizvirza stingrus pieņēmumus par datiem.

Lai ieviestu Support Vector Machine: datu zinātnes bibliotēkas pakalpojumā Python- SciKit Learn, PyML, SVMStrukturālā Python, LIBSVM un datu zinātnes bibliotēkas R-Klar, e1071.

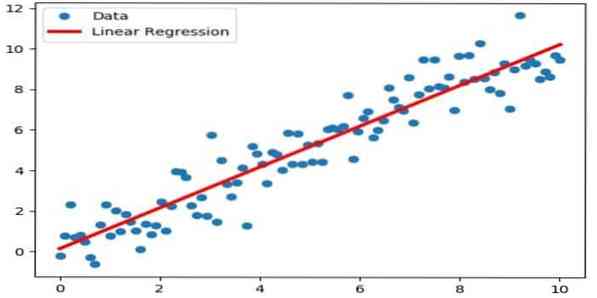

3. Lineārā regresija

Lineārā regresija ir tieša pieeja, ko izmanto, lai modelētu saistību starp atkarīgo mainīgo un vienu vai vairākiem neatkarīgiem mainīgajiem. Ja ir viens neatkarīgs mainīgais, tad to sauc par vienkāršu lineāro regresiju. Ja ir pieejami vairāki neatkarīgi mainīgie, to sauc par vairāku lineāru regresiju.

Šo formulu izmanto, lai novērtētu reālās vērtības, piemēram, māju cenu, zvanu skaitu, kopējo pārdošanas apjomu, pamatojoties uz nepārtrauktiem mainīgajiem lielumiem. Šeit attiecība starp neatkarīgajiem un atkarīgajiem mainīgajiem tiek noteikta, piemērojot labāko līniju. Šī vislabāk atbilstošā līnija ir pazīstama kā regresijas līnija, un to attēlo lineārs vienādojums

Y = a * X + b.

šeit,

- Y - atkarīgs mainīgais

- a - slīpums

- X - neatkarīgs mainīgais

- b - pārtvert

Šo mašīnmācīšanās metodi ir viegli izmantot. Tas tiek izpildīts ātri. To var izmantot biznesā pārdošanas prognozēšanai. To var izmantot arī riska novērtēšanā.

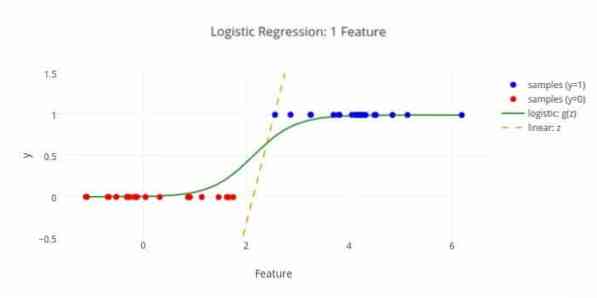

4. Loģistiskā regresija

Šeit ir vēl viens mašīnmācīšanās algoritms - loģistiskā regresija vai logita regresija, ko izmanto, lai novērtētu diskrētas vērtības (bināras vērtības, piemēram, 0/1, jā / nē, patiesa / nepatiesa), pamatojoties uz noteiktu neatkarīgā mainīgā lielumu kopu. Šī algoritma uzdevums ir paredzēt incidenta varbūtību, pielāgojot datus logit funkcijai. Tās izejas vērtības ir no 0 līdz 1.

Formulu var izmantot dažādās jomās, piemēram, mašīnmācībā, zinātniskajā disciplīnā un medicīnas jomās. To var izmantot, lai prognozētu konkrētas slimības rašanās bīstamību, pamatojoties uz novērotajām pacienta īpašībām. Loģistisko regresiju var izmantot, lai prognozētu klienta vēlmi iegādāties produktu. Šo mašīnmācīšanās paņēmienu izmanto laika prognozēšanā, lai prognozētu lietus iespējamību.

Loģistisko regresiju var iedalīt trīs veidos -

- Binārā loģistiskā regresija

- Daudznominālā loģistiskā regresija

- Parastā loģistiskā regresija

Loģistiskā regresija ir mazāk sarežģīta. Turklāt tas ir izturīgs. Tas var apstrādāt nelineārus efektus. Tomēr, ja apmācības dati ir reti un ar lielu dimensiju, šis ML algoritms var pārspīlēt. Tas nevar paredzēt nepārtrauktus rezultātus.

5. K-Tuvākais kaimiņš (KNN)

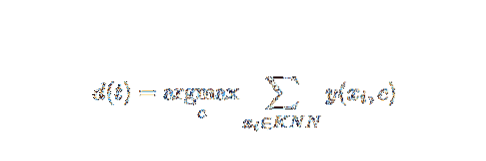

K-tuvākais kaimiņš (kNN) ir labi zināma statistikas pieeja klasifikācijai, un gadu gaitā tā ir plaši pētīta un agri piemērota kategorizēšanas uzdevumiem. Tā darbojas kā neparametriska metodoloģija klasifikācijas un regresijas problēmām.

Šī AI un ML metode ir diezgan vienkārša. Tas nosaka testa dokumenta kategoriju t, pamatojoties uz k dokumentu kopas balsošanu, kas attālumam, kas parasti ir Eiklida attālums, ir vistuvāk t. Būtiskais lēmuma noteikums, kas dots kNN klasifikatora pārbaudes dokumentam t, ir:

Ja y (xi, c) ir binārā klasifikācijas funkcija apmācības dokumentam xi (kas atgriež vērtību 1, ja xi ir apzīmēts ar c, vai 0 citādi), šis noteikums apzīmē ar t kategoriju, kurai tiek piešķirts visvairāk balsu k - tuvākā apkārtne.

Mēs varam tikt pieskaitīti KNN mūsu reālajai dzīvei. Piemēram, ja vēlaties uzzināt dažus cilvēkus, par kuriem jums nav informācijas, jūs, iespējams, dodat priekšroku izlemt par viņa tuvajiem draugiem un tāpēc par lokiem, kuros viņš pārvietojas, un piekļūtu savai informācijai. Šis algoritms ir skaitļošanas ziņā dārgs.

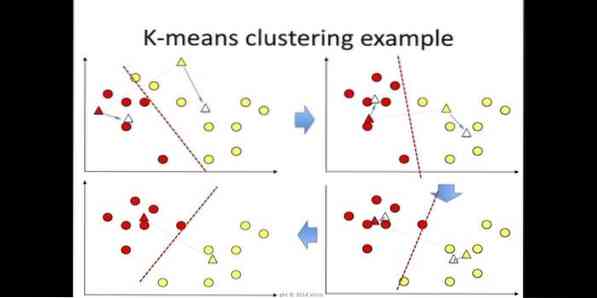

6. K-nozīmē

k-mean cluster ir nepieskatītas mācīšanās metode, kas ir pieejama klasteru analīzei datu ieguvē. Šī algoritma mērķis ir sadalīt n novērojumus k kopās, kur katrs novērojums pieder pie tuvākā klastera vidējā līmeņa. Šis algoritms tiek izmantots tirgus segmentēšanā, datorvīzijā un astronomijā starp daudzām citām jomām.

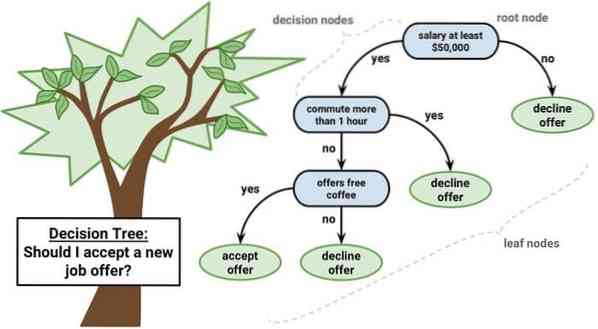

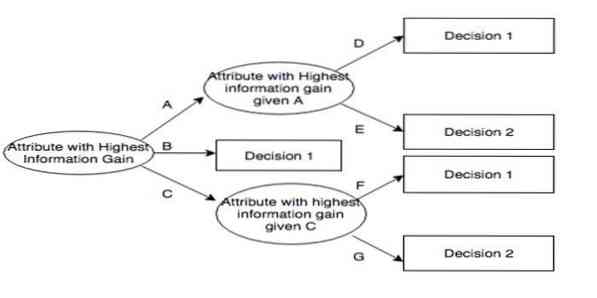

7. Lēmumu koks

Lēmumu koks ir lēmumu atbalsta rīks, kas izmanto grafisko attēlojumu, t.i.e., kokam līdzīgs grafiks vai lēmumu modelis. To parasti izmanto lēmumu analīzē un arī populāru mašīnmācīšanās rīku. Lēmumu koki tiek izmantoti operāciju izpētē un operāciju vadībā.

Tam ir blokshēmiska struktūra, kurā katrs iekšējais mezgls attēlo atribūta “testu”, katrs atzars - testa rezultātu un katrs lapu mezgls apzīmē klases etiķeti. Maršruts no saknes līdz lapai ir pazīstams kā klasifikācijas noteikumi. Tas sastāv no trīs veidu mezgliem:

- Lēmuma mezgli: parasti attēlo kvadrāti,

- Izredzes mezgli: parasti attēlo ar apļiem,

- Beigu mezgli: parasti attēlo trīsstūri.

Lēmumu koks ir vienkārši saprotams un interpretējams. Tas izmanto baltās kastes modeli. Tāpat to var apvienot ar citām lēmumu pieņemšanas metodēm.

8. Gadījuma mežs

Izlases mežs ir populāra ansambļa mācīšanās metode, kas darbojas, apmācības laikā konstruējot daudzus lēmumu kokus un izsniedzot kategoriju, kas ir katra koka kategoriju (klasifikācijas) vai vidējās prognozes (regresijas) režīms.

Šī mašīnmācīšanās algoritma izpildlaiks ir ātrs, un tas spēj strādāt ar nelīdzsvarotiem un trūkstošiem datiem. Tomēr, kad mēs to izmantojām regresijai, tas nevar paredzēt ārpus treniņu datu diapazona, un tas var pārspēt datus.

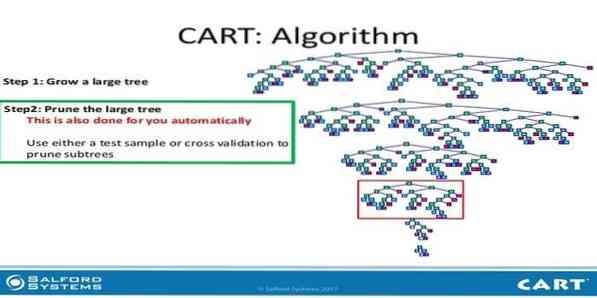

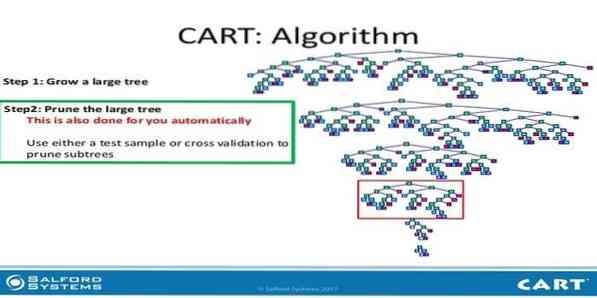

9. CART

Klasifikācijas un regresijas koks (CART) ir viena veida lēmumu koks. Lēmumu koks darbojas kā rekursīvā sadalīšanas pieeja, un CART sadala katru ievades mezglu divos bērnu mezglos. Katrā lēmumu koku līmenī algoritms identificē nosacījumu - kuru mainīgo un līmeni izmantot ievades mezgla sadalīšanai divos pakārtotajos mezglos.

CART algoritma darbības ir norādītas zemāk:

- Veikt ievades datus

- Labākais Split

- Labākais mainīgais

- Sadaliet ievades datus kreisajā un labajā mezglā

- Turpiniet 2. – 4. Darbību

- Lēmumu koku atzarošana

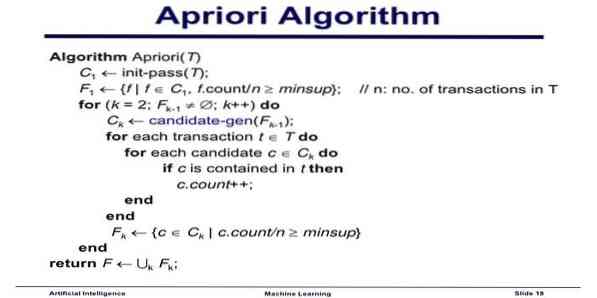

10. Apriori mašīnmācīšanās algoritms

Apriori algoritms ir kategorizēšanas algoritms. Šo mašīnmācīšanās paņēmienu izmanto, lai šķirotu lielu datu apjomu. To var arī izmantot, lai sekotu līdzi tam, kā veidojas attiecības un tiek veidotas kategorijas. Šis algoritms ir neuzraudzīta mācību metode, kas ģenerē asociācijas noteikumus no konkrētās datu kopas.

Apriori mašīnmācīšanās algoritms darbojas kā:

- Ja vienumu kopa notiek bieži, tad visas vienumu kopas apakškopas notiek arī bieži.

- Ja vienumu kopa notiek reti, tad visām vienumu kopām ir arī reti sastopamas.

Šis ML algoritms tiek izmantots dažādās lietojumprogrammās, piemēram, zāļu blakusparādību noteikšanai, tirgus grozu analīzei un automātiskās pabeigšanas lietojumiem. To ir vienkārši īstenot.

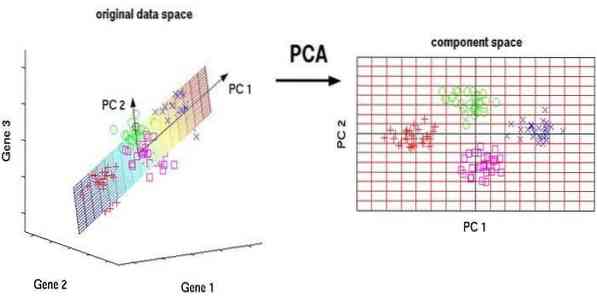

11. Galveno komponentu analīze (PCA)

Galveno komponentu analīze (PCA) ir bez uzraudzības algoritms. Jaunās funkcijas ir ortogonālas, tas nozīmē, ka tās nav savstarpēji saistītas. Pirms PCA veikšanas jums vienmēr vajadzētu normalizēt datu kopu, jo transformācija ir atkarīga no mēroga. Ja jūs to nedarīsit, iezīmes, kas ir visnozīmīgākajā mērogā, dominēs jaunajos galvenajos komponentos.

PCA ir daudzpusīga tehnika. Šis algoritms ir bez piepūles un vienkāršs ieviešanā. To var izmantot attēlu apstrādē.

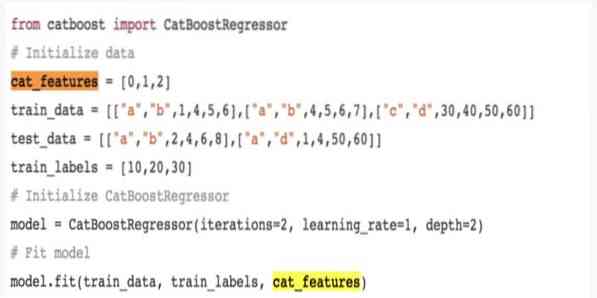

12. CatBoost

CatBoost ir atvērtas izcelsmes mašīnmācīšanās algoritms, kas nāk no Yandex. Nosaukums “CatBoost” nāk no diviem vārdiem “Category” un “Boosting.'To var apvienot ar dziļu mācību sistēmu, t.i.e., Google TensorFlow un Apple Core ML. CatBoost var strādāt ar daudziem datu tipiem, lai atrisinātu vairākas problēmas.

13. Iteratīvs 3. dichotomiser (ID3)

Iterative Dichotomiser 3 (ID3) ir lēmumu koku mācīšanās algoritmisks noteikums, ko iesniedza Ross Quinlan un kas tiek izmantots, lai piegādātu lēmumu koku no datu kopas. Tas ir C4 priekšgājējs.5 algoritmisko programmu un tiek izmantots mašīnmācīšanās un valodas komunikācijas procesa jomās.

ID3 var pārspīlēt ar apmācības datiem. Šo algoritmisko kārtulu ir grūtāk izmantot nepārtrauktiem datiem. Tas negarantē optimālu risinājumu.

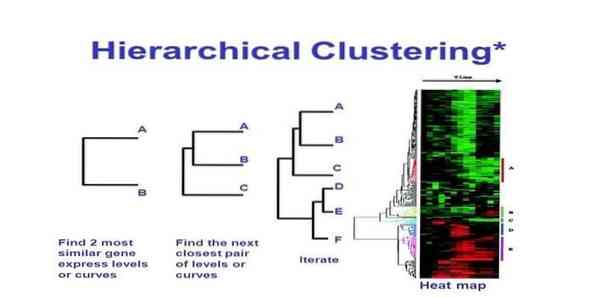

14. Hierarhiska kopu veidošana

Hierarhiska kopu veidošana ir klasteru analīzes veids. Hierarhiskā klasterizācijā datu ilustrēšanai tiek izstrādāts klasteru koks (dendrogramma). Hierarhiskā kopu veidošanā katra grupa (mezgls) sasaista divas vai vairākas pēctecības grupas. Katrs mezgls klastera kokā satur līdzīgus datus. Mezgli grupējas diagrammā blakus citiem līdzīgiem mezgliem.

Algoritms

Šo mašīnmācīšanās metodi var iedalīt divos modeļos - no apakšas uz augšu vai no augšas uz leju:

No apakšas uz augšu (Hierarhiskā aglomeratīvā kopu veidošana, HAC)

- Šīs mašīnmācīšanās tehnikas sākumā ņemiet katru dokumentu kā vienu kopu.

- Jaunā kopā apvienoti divi vienumi vienlaikus. Tas, kā apvieno apvienošanos, ietver aprēķina starpību starp katru iekļauto pāri un līdz ar to arī alternatīvajiem paraugiem. Lai to izdarītu, ir daudz iespēju. Daži no tiem ir:

a. Pilnīga sasaiste: Tālākā pāra līdzība. Viens ierobežojums ir tāds, ka neiecietība var izraisīt tuvu grupu apvienošanos vēlāk, nekā tas ir optimāli.

b. Viena saite: Tuvākā pāra līdzība. Tas var izraisīt priekšlaicīgu apvienošanos, lai gan šīs grupas ir diezgan atšķirīgas.

c. Grupas vidējais rādītājs: līdzība starp grupām.

d. Centroid līdzība: katra iterācija apvieno kopas ar galveno līdzīgo centrālo punktu.

- Kamēr visi vienumi netiek apvienoti vienā kopā, savienošanas process turpinās.

No augšas uz leju (daloša kopa)

- Dati sākas ar kombinētu kopu.

- Klasteris sadalās divās atšķirīgās daļās, ņemot vērā zināmu līdzības pakāpi.

- Klasteri atkal un atkal sadalās divās daļās, līdz kopās ir tikai viens datu punkts.

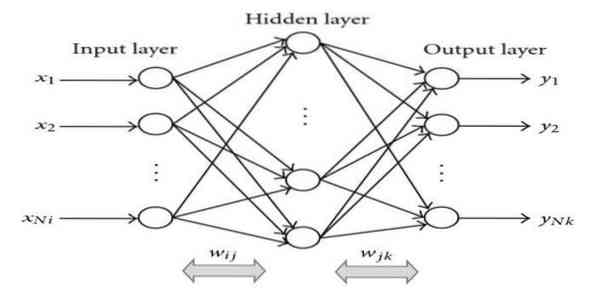

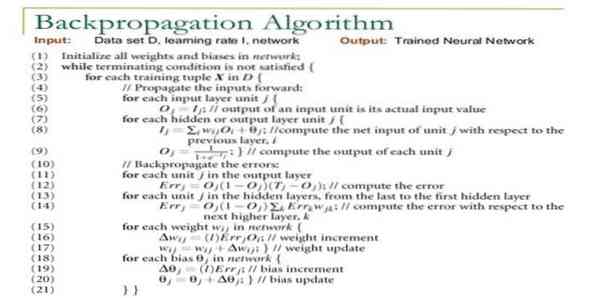

15. Muguras pavairošana

Muguras izplatīšana ir uzraudzīts mācību algoritms. Šis ML algoritms nāk no ANN (mākslīgo neironu tīklu) apgabala. Šis tīkls ir daudzslāņu pārsūtīšanas tīkls. Šī paņēmiena mērķis ir izstrādāt noteiktu funkciju, modificējot ieejas signālu iekšējos svarus, lai iegūtu vēlamo izejas signālu. To var izmantot klasifikācijai un regresijai.

Atpakaļizplatīšanas algoritmam ir dažas priekšrocības, t.i.e., to ir viegli īstenot. Algoritmā izmantoto matemātisko formulu var piemērot jebkuram tīklam. Aprēķināšanas laiku var samazināt, ja svars ir mazs.

Atpakaļizplatīšanas algoritmam ir daži trūkumi, piemēram, tas var būt jutīgs pret trokšņainiem datiem un nepieļaujamiem rādītājiem. Tā ir pieeja, kas pilnībā balstīta uz matricu. Šī algoritma faktiskā veiktspēja ir pilnībā atkarīga no ievades datiem. Izeja var nebūt skaitliska.

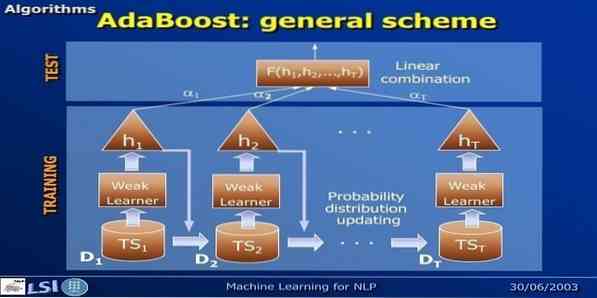

16. AdaBoost

AdaBoost nozīmē adaptīvo veicināšanu, mašīnmācīšanās metodi, ko pārstāv Javs Freunds un Roberts Šapīrs. Tas ir meta-algoritms, un to var integrēt ar citiem mācību algoritmiem, lai uzlabotu to veiktspēju. Šis algoritms ir ātri un ērti lietojams. Tas labi darbojas ar lielām datu kopām.

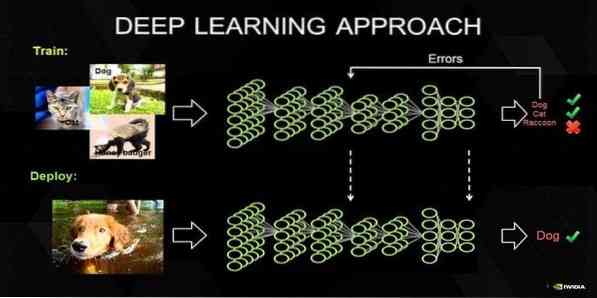

17. Dziļa mācīšanās

Dziļa mācīšanās ir paņēmienu kopums, kuru iedvesmojis cilvēka smadzeņu mehānisms. Divas primārās dziļas mācības, t.i.e., Teksta klasifikācijā tiek izmantoti konvertācijas neironu tīkli (CNN) un atkārtoti neironu tīkli (RNN). Tiek izmantoti arī padziļinātas mācīšanās algoritmi, piemēram, Word2Vec vai GloVe, lai iegūtu augsta ranga vārda vektoru attēlojumus un uzlabotu klasifikatoru precizitāti, kas tiek apmācīti ar tradicionālajiem mašīnmācīšanās algoritmiem.

Šai mašīnmācīšanās metodei tradicionālo mašīnmācīšanās algoritmu vietā ir nepieciešams daudz apmācības paraugu, t.e., vismaz miljoniem iezīmētu piemēru. Turpretī tradicionālās mašīnmācīšanās metodes sasniedz precīzu slieksni visur, kur vairāk apmācības paraugu pievienošana vispār neuzlabo to precizitāti. Dziļu mācību klasifikatori pārspēj labākus rezultātus ar vairāk datu.

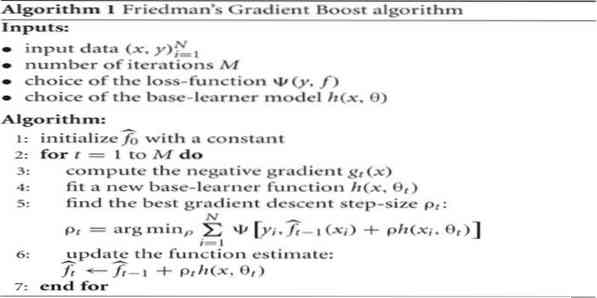

18. Gradienta palielināšanas algoritms

Gradienta palielināšana ir mašīnmācīšanās metode, ko izmanto klasifikācijai un regresijai. Tas ir viens no spēcīgākajiem veidiem, kā attīstīt prognozēšanas modeli. Gradienta palielināšanas algoritmam ir trīs elementi:

- Zaudēšanas funkcija

- Vājš izglītojamais

- Piedevas modelis

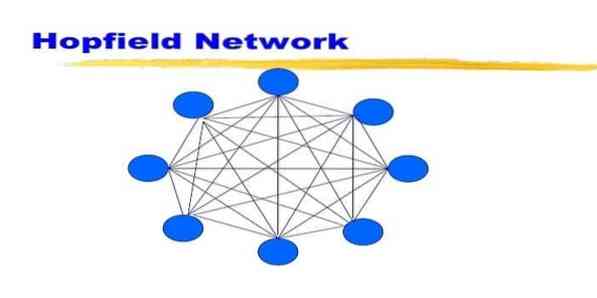

19. Hopfīlda tīkls

Hopfīlda tīkls ir viena veida atkārtots mākslīgais neironu tīkls, kuru Džons Hopfīlds sniedza 1982. gadā. Šī tīkla mērķis ir saglabāt vienu vai vairākus modeļus un atsaukt visus modeļus, pamatojoties uz daļēju ievadi. Hopfīlda tīklā visi mezgli ir gan ieejas, gan izejas un pilnībā savstarpēji savienoti.

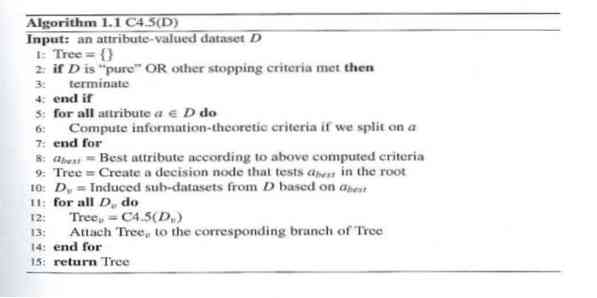

20. C4.5

C4.5 ir lēmumu koks, kuru izgudroja Ross Kvinlans. Tā ID3 jaunināšanas versija. Šī algoritmiskā programma ietver dažus pamata gadījumus:

- Visi saraksta paraugi pieder līdzīgai kategorijai. Tas izveido lapu mezglu lēmumu kokam, kurā teikts, ka jāizlemj par šo kategoriju.

- Tas rada lēmuma mezglu augstāk kokā, izmantojot paredzamo klases vērtību.

- Tas rada lēmuma mezglu augstāk kokā, izmantojot paredzamo vērtību.

Beigu domas

Ir ļoti svarīgi izmantot pareizu algoritmu, kura pamatā ir jūsu dati un domēns, lai izstrādātu efektīvu mašīnmācīšanās projektu. Lai izprastu kritisko atšķirību starp katru mašīnmācīšanās algoritmu, ir svarīgi pievērsties arī tam, kad izvēlos kādu.“Kā mašīnmācīšanās pieejā mašīna vai ierīce ir iemācījušies, izmantojot mācību algoritmu. Es esmu pārliecināts, ka šis raksts palīdz jums izprast algoritmu. Ja jums ir kādi ieteikumi vai jautājumi, lūdzu, nekautrējieties jautāt. Turpini lasīt.

Phenquestions

Phenquestions